在我看来,机器人协议是站长对网站行使控制权的执行文件,这是我们作为站长最基本的权利。它是搜索引擎蜘蛛在抓取网站之前必须面对的第一个网关,所以机器人协议的重要性可想而知。都说细节决定成败,所以越重要的事情,细节就是[...]

在我看来,机器人协议是站长对网站行使控制权的执行文件,这是我们作为站长最基本的权利。它是搜索引擎蜘蛛在抓取网站之前必须面对的第一个网关,所以机器人协议的重要性可想而知。都说细节决定成败,所以事情越重要,细节就越重要,一个人经常不小心忽略的细节,最后可能会成为你致命的一击。我之所以这么说,是因为我几乎成了这个问题的反面教材。幸运的是,及时发现可以被视为弥补损失。之所以想马上和大家分享,是希望大家以后做自己的站的时候不要再犯类似的错误。

其实今天就发生了,过程是这样的:因为小明的SEO博客刚刚完成,前几天网站上线后,发现还有很多小问题需要处理。为了避免网站在调整期间被搜索引擎抓取,我在robots协议中写了一条指令,禁止所有搜索引擎抓取网站的任何部分。网站的调整持续了好几天(之所以这么久,是因为我不能容忍瑕疵,也不知道是不是一种强迫症),直到昨天2月3日才完全完成,但在这期间,我坚持每天都要加原创文章。昨天查了网站,解决了所有问题后,我更换了机器人协议,发了一个帖子吸引蜘蛛,希望爬虫能快点来爬我的网站。就这样,今天早上发现网站还是没有收录,就去百度站长工具平台看看我的网站是什么样的。进去的时候很震惊,因为看到了以下信息(如图):

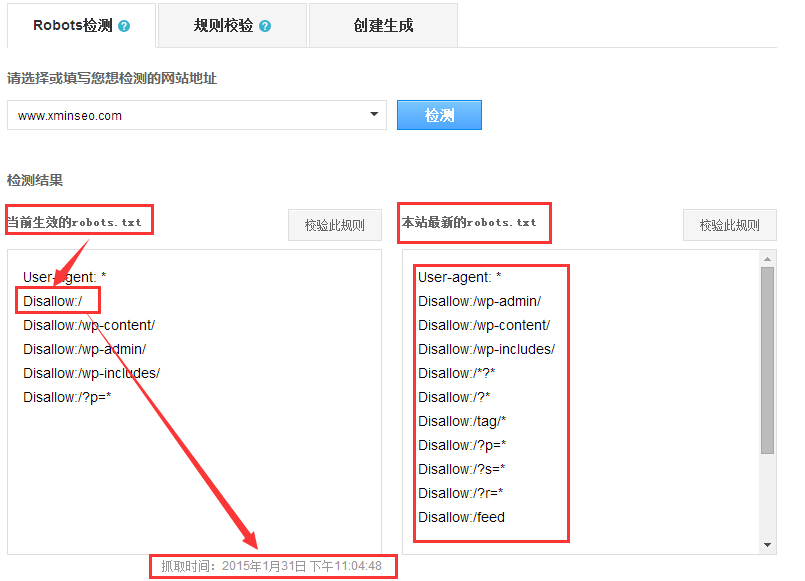

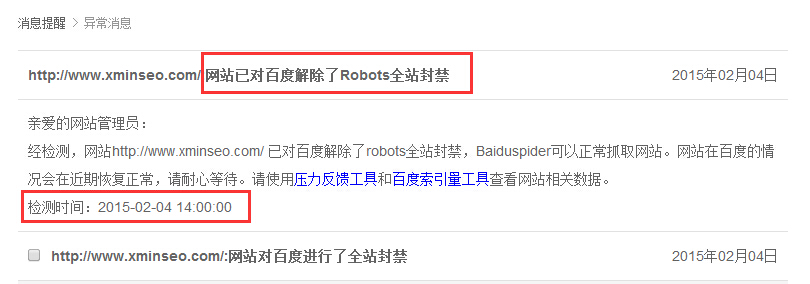

我的网站已经全面封禁百度,检测时间是今天(2月4日)凌晨5点,这让我像张耳和尚一样犯难,太不科学了,因为我昨天2月3日上午就改了网站的机器人协议,真的很奇怪。就在我百思不得其解的时候,我终于通过站长平台工具的“机器人检测”找到了答案。请看下图:

原来百度蜘蛛在我的网站蜘蛛上线后第三天就抓取了我网站的机器人协议,所以现在有效的协议就是我屏蔽所有蜘蛛时它抓取的那个,这个网站最新的机器人协议还没有生效。现在终于明白了。现在知道原因了,就好办了。于是我立即提交了协议并进行更新,如下图所示:

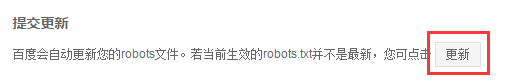

协议将在更新后一分钟内更新,如下图所示:

可以看到这个站点上最新的机器人已经生效了,所以下午,当我再次进入百度站长平台的时候,我收到了新的消息,如下图所示:

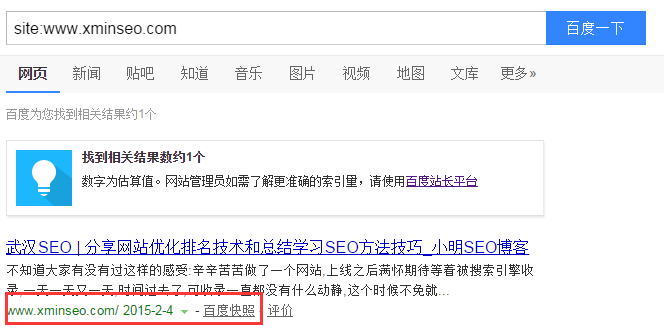

到目前为止,网站已经通过机器人协议解除了对百度的全面封禁,检测时间显示今天下午正好两点。到了晚上,已经快三个小时了。当我再次查看网站的列表时,网站的主页已经列出来了。如下图:

网站终于收录了,但最让我开心的是,我通过自己的努力发现并解决了问题,这是我今天最大的收获。当然,如果我找不到这个问题,可能网站在十天半内不会有任何改善,所以我想提醒大家,在禁止蜘蛛之后,一定要记得在后期解封的时候及时更新机器人协议。这是一个不容忽视的小细节。也许根据我自己的常识,我觉得输入“http:\域名\robots.txt”来检查网站的协议是否被更改就足够了,但实践证明这种方式并不完全可靠,所以这次一定要记住我的经验教训。机器人一旦做出调整,一定要记得及时提交更新,否则被不该抓的蜘蛛抓到或者把蜘蛛挡在门外耽误时间,真的很遗憾。

小技巧:只看时间,时钟已经转到了第二天。本文写于2月4日,但是发布时间已经转到2月5日,所以文中提到的“今天”是2月4日,希望大家不要搞混了。